14/05/2025L'AI nella medicina migliora del 28%: a che punto siamo?

Se mi segui da un po', sai che mi entusiasma parecchio l'idea che l'AI possa portarci concretamente ad avere una qualità della vita migliore.

E volevo fare una riflessione su questo tema.

Negli ultimi mesi ci sono state diverse affermazioni legate a questo…

A Gennaio, Dario Amodei, CEO di Anthropic, ha affermato che: “possiamo fare 100 anni di progressi in aree come la biologia in cinque o dieci anni”.

Anche Demis Hassabis, CEO di Google Deepmind, sostiene che: “l’AI potrebbe porre fine alle malattie.”

Ma ad oggi che evidenze ci sono? 🤔

Ci sono già stati diversi casi in cui l’AI ha aiutato a migliorare la qualità della vita alle persone.

Vediamo qualche esempio concreto 👇

1️⃣ Eyevatar

Qualche mese fa, in Gran Bretagna, è stato completato con successo il primo intervento clinico utilizzando una nuova tecnologia chiamata Eyevatar.

La paziente era legalmente cieca con una vista di 20/1400 (praticamente zero) ma dopo l’intervento è passata a 20/16, anche meglio della vista normale.💡

In pratica con Eyevatar l’AI crea una mappa digitale precisissima e tridimensionale dell'occhio e simula migliaia di interventi laser virtuali diversi selezionando l'intervento "perfetto" per la morfologia unica dell'occhio.

Assurdo vero? 💣

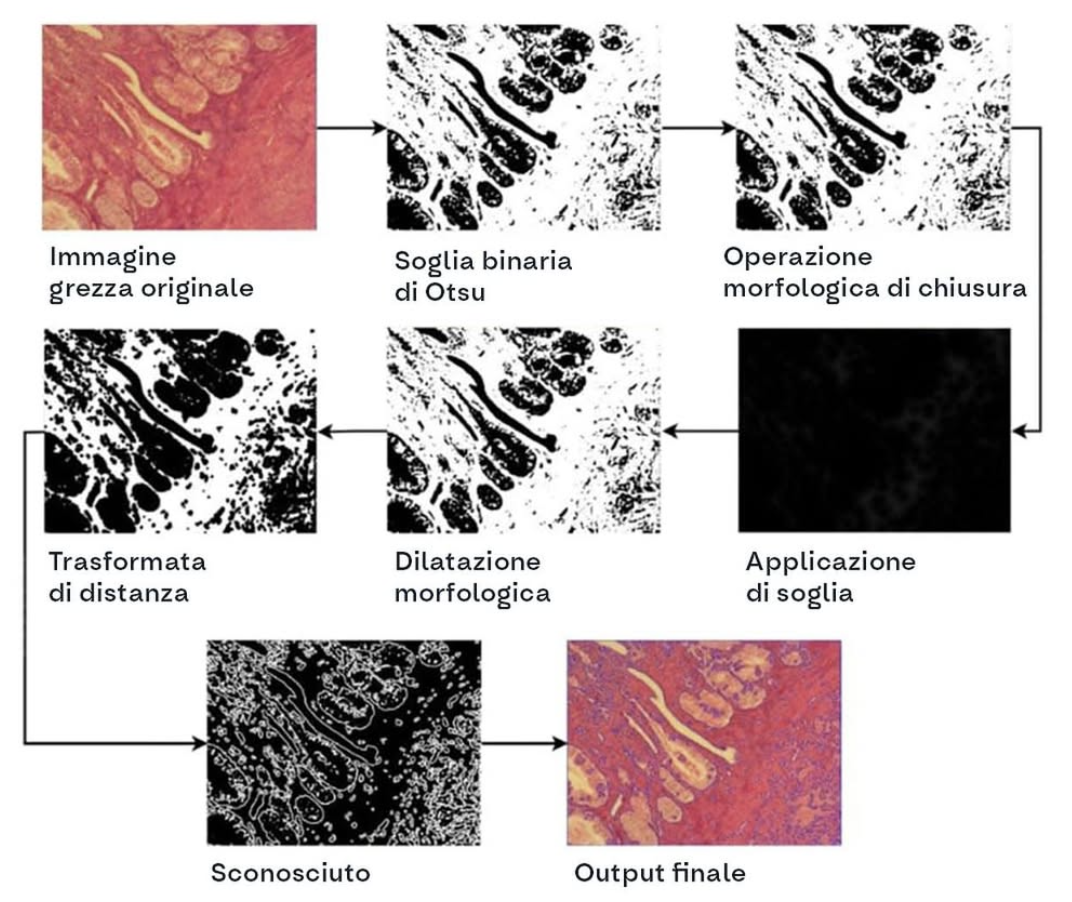

2️⃣ Il modello ECgMPL per la diagnosi del cancro

Un altro modello recentissimo, chiamato ECgMPL, ha raggiunto una precisione incredibile nella diagnosi automatizzata di vari tipi di tumori:

- Endometrio: 99,26%

- Colon-retto: 98,57%

- Mammella: 98,20%

- Bocca: 97,34%

Queste sono percentuali enormi, considerando che prima la precisione massima con sistemi automatizzati era neanche il 79-80%.

E potrei fartene altri di esempi…

Ma c’è ancora un problema quando si parla dell’AI applicata alla medicina…

L’affidabilità. ❌

Ed è anche su questo che OpenAI sta lavorando…

Infatti, pochi giorni fa ha rilasciato HealthBench.

Facciamo un passo indietro per capire di cosa si tratta. 🙌

HealthBench è un benchmark open-source che serve a testare quanto bene funzionano i modelli AI in situazioni sanitarie reali.

Per condurre lo studio, sono state create 5.000 conversazioni realistiche tra utenti (medici o pazienti) e modelli AI.

262 medici hanno poi valutato le risposte dei modelli usando delle “pagelle” personalizzate, chiamate rubriche.💡

Queste rubriche contengono quasi 50.000 criteri diversi per capire, ad esempio:

- Se il modello ha dato informazioni corrette.

- Se ha comunicato in modo chiaro.

- Se ha chiesto più dettagli quando mancavano informazioni importanti.

Vediamo insieme cosa è emerso.

I modelli sono migliorati tanto nell’ultimo periodo.

Nel giro di pochi mesi, infatti, gli ultimi modelli (come o3 e GPT-4.1 nano) hanno segnato un miglioramento del 28%rispetto alle generazioni precedenti, soprattutto su affidabilità e precisione. 🔥

Sembra che il modello migliore sia o3 di OpenAI, che ha ottenuto il 60% del punteggio massimo. 🏆

E alcuni modelli piccoli e super economici riescono già a battere versioni più vecchie e costose.

Però nonostante tutto, anche i modelli migliori sbagliano ancora, soprattutto nei casi più complessi.

Per questo, è importante essere cauti visto l’ambito in cui la massima precisione è fondamentale.

Volevo anche approfondire uno dei metodi che hanno utilizzato i ricercatori per esaminare l’affidabilità delle risposte: il metodo worst-of-n performance.

Immagina di chiedere X volte la stessa cosa a un modello.

Se un modello dà X-1 risposte ottime e una pessima, la pessima pesa tantissimo, perché non ci si può permettere di commettere errori.

L’asse orizzontale è quante volte hai chiesto la stessa cosa (da 1 a 16) mentre l’asse verticale è quanto è buona la peggior risposta (più alto è meglio).

Vediamo che o3 è il modello più affidabile: anche la sua peggior risposta è molto buona. 🚀

Più scendiamo verso il basso, meno affidabili sono gli altri modelli.

Un altro aspetto interessante che deriva dallo studio è:

“I medici umani possono ancora migliorare le risposte dei modelli AI?"

Per scoprirlo, hanno fatto un esperimento:

- Hanno dato ai medici delle conversazioni specifiche e le risposte scritte dall’AI.

- Hanno chiesto loro di migliorarle, ove possibile.

- Poi hanno confrontato il risultato finale con le risposte originali dell’AI.

Il grafico confronta la qualità delle risposte in base a chi le ha scritte o migliorate: colonne più alte = risposte migliori

I medici riuscivano a migliorare le risposte dei modelli del 2024.

Ma non riuscivano a migliorare quelle dei modelli del 2025, come GPT-4.1 o o3.

Questo vuol dire che le risposte dei nuovi modelli sono così buone che anche esperti umani non riescono ad aggiungere molto altro.

Per chiudere volevo fare un paio di considerazioni al volo. 👀

Poche settimane fa abbiamo avuto l’annuncio dell’AI Co-Scientist di Google: un sistema basato sul modello Gemini 2.0 che potrebbe accelerare la velocità delle scoperte scientifiche. 🏎️

Oggi abbiamo visto anche i risultati molto impressionanti di modelli come o3 di OpenAI.

Questo significa che la ricerca nel settore sta correndo anche in ambiti più critici come la medicina. 🙌

E questa è una cosa iper positiva (secondo me).

È chiaro che dobbiamo essere cauti e a maggior ragione, in un ambito come questo, assicurarci che non ci sia margine di errore.

Però, visti i risultati, siamo sulla buona strada. 🛣️

Tu che ne pensi? In futuro pensi che riusciresti a fidarti di una diagnosi fatta da un’AI?

Giacomo Ciarlini - Head of Content & Education - Datapizza

Alexandru Cublesan - Media Manager & Creator - Datapizza