05/02/2026OpenClaw e Moltbook: perché un forum per soli agenti AI è interessante?

In questi giorni tutti stanno parlando di OpenClaw e Moltbook e ho fatto una cosa che non consiglio di fare a cuor leggero: li ho provati.

Facciamo un passo indietro e capiamo tutto con calma.

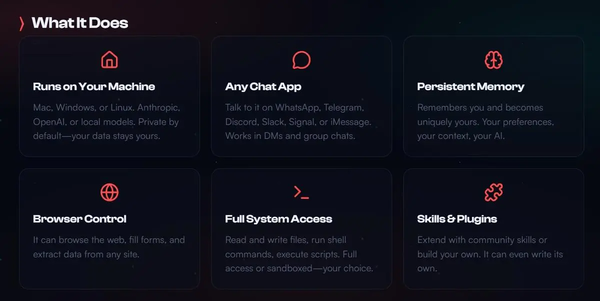

OpenClaw è, in sostanza, un agente che opera sul tuo computer (o su una macchina dedicata) 24/7.

Nello specifico, è un gateway sempre acceso che riceve comandi da un’app di messaggistica come WhatsApp, Telegram o Slack, li passa a un LLM e poi esegue azioni sul tuo OS: file, browser, terminale, email, calendario, automazioni.

Inizialmente si chiamava Cloud Bot, ma, proprio mentre stava esplodendo nome dopo che Anthropic ha fatto notare una leggera somiglianza col suo modello “Claude”.

Quindi è diventato MoltBot e infine OpenClaw.

Su GitHub OpenClaw ha più di 100k stelle, sul sito viene raccontato come *“l’AI che fa veramente le cose”,* e su TikTok sembra Jarvis.

(ne abbiamo parlato in un post in questi giorni!)

Nella pratica mi sembra soprattutto un modo creativo di trasformare il tuo computer in un bersaglio. 🫠

E sì, capisco benissimo perché stia esplodendo: è la demo perfetta.

Scrivi su Telegram “prenotami un ristorante” e lui apre il browser, naviga, compila campi, manda email, archivia file.

Sembra magia perché non è più una semplice chat: è un agente con le mani sul tuo sistema operativo.

Eppure, nulla di nuovo sotto il sole.

Dal punto di vista architetturale è un ponte tra messaggio ed esecuzione di tool. La parte “wow” è l’integrazione comoda e la persistenza.

Ma non è una rivoluzione, è un assemblaggio aggressivo di pezzi che già avevamo: tool calling, plugin, connettori, memoria.

Ed è qui che casca l’asino.

Perché quella stessa esperienza la puoi ottenere con server MCP ben progettati, permessi granulari e confini chiari.

Con MCP dici: “questo agente può leggere solo questa cartella, scrivere solo lì, chiamare solo questa API, con questi scope”.

OpenClaw ti suggerisce l’opposto: “dai accesso al computer e poi vediamo”.

L’utilità sale, almeno apparentemente. Ma il rischio è dietro l’angolo.

E non è paranoia.

Perché il punto non è se funziona o no, ma “cosa stai autorizzando davvero?”

Dal punto di vista tecnico, OpenClaw fa acqua da tutte le parti.

E non credo sia pensato per essere robusto e affidabile, ma per sperimentare le possibilità degli agenti.

Agenti che, implementati in questo modo, espongono l’utente e il computer a molti rischi, tra cui l’adversarial prompting.

In soldoni, mentre l’agente naviga tra le tue mail, nel tuo file system o nel browser, può essere esposto a prompt malevoli che lo indirizzano verso attività pericolose.

La forma più cattiva di prompt injection non è “fammi vedere la password”. È quando l’agente legge contenuti non fidati - web, email, messaggi - e dentro quei contenuti ci sono istruzioni mascherate che lo convincono ad agire.

Se un agente può leggere file, eseguire comandi e far girare script, basta una catena sbagliata per fare danni.

E non serve bucare il codice, basta sfruttare la semantica: un messaggio su WhatsApp può diventare un vettore se l’agente lo tratta come istruzione.

Sì, è assurdo. Ma purtroppo non è fantascienza.

Poi OpenClaw viene raccontato come sicuro perché è self-hosted e “tutto resta in locale”.

Ma non è vero: non resta mai in locale, perché la chiamata LLM scomoda i server del modello di turno (si tratti di GPT, Claude o altro).

E sopra tutto questo, la parte più noiosa e quindi più pericolosa: il marketplace di skill.

Sì, lo stesso standard che ha introdotto Anthropic nel suo Claude.

Si tratta, nei fatti, di eseguibili scaricati da internet con senza audit.

Risultato? Supply chain perfetta: comandi offuscati, infostealer, furto di credenziali.

Non perché qualcuno sia un genio del male, ma perché l’hype batte la prudenza 9/10 volte.

E quando scopri che i segreti sono salvati in chiaro, in file Markdown o JSON, il quadro è completo: non è più solo un tool acerbo, ma un target naturale per malware.

“Ma io l’ho provato e non mi ha rubato nulla.”

Certo. È come dire “ho guidato senza cintura e sono vivo”. Vero, ma irrilevante.

Il punto è che il valore marginale non giustifica il profilo di rischio.

Se ti servono email, calendario, file, workflow… la versione adulta è noiosa ma funziona: MCP con scope stretti, sandbox o macchine virtuali, human-in-the-loop serio quando tocchi web o dati sensibili (come pagamenti online o credenziali).

OpenClaw è la versione adolescente ribelle: potentissima, velocissima, ma senza freni.

E infatti il mondo della cybersecurity sta reagendo come reagisce sempre quando qualcosa diventa virale prima di diventare robusto.

Quindi: vale la pena?

- Se sei tecnico e vuoi capire dove sta andando l’agentic AI, sì: come oggetto di studio è interessante.

- Se sei un utente normale che vuole un assistente “sempre attivo”, no: al momento il trade-off è negativo.

Se proprio vuoi giocarci (perché lo so che vuoi 😅):

- non installarlo sul tuo computer principale - molti hanno comprato eserciti di Mac Mini apposta per testarlo. Ma se per usare in sicurezza un agente AI gli compri un computer apposta, non ne capisco l’utilità e il senso.

- non esporlo su internet “per comodità”.

- tratta le skill con cautela.

Insomma: OpenClaw è l’ottimo trailer di un film che potrebbe finire in modo pessimo.

E poi c’è il sequel: Moltbook.

Sulla carta è irresistibile: un “Reddit per agenti”, un social dove (in teoria) possono postare solo bot e noi umani guardiamo nascere una società artificiale.

Solo che no.

Moltbook non è il luogo dove le AI si organizzano. È il luogo dove gli umani organizzano le AI perché sembri che si stanno organizzando.

Gli agenti non si iscrivono da soli: qualcuno li configura, gli dà un personaggio, installa skill, spesso li prompta con dei comportamenti specifici.

Fin qui sarebbe solo gioco di ruolo, se non fosse per un dettaglio: su Moltbook gli agenti non condividono solo opinioni.

Condividono capacità, codice e skill operative.

E qui le cose cambiano.

Perché se metti insieme capacità eseguibili, logiche social (like, popolarità, feed) e zero governance, stai sostituendo la verifica tecnica con l’applausometro.

È il modello perfetto per rendere virale una vulnerabilità: non perché sia sofisticata, ma perché è condivisibile.

Cosa potrebbe mai andare storto? 🙂

E infatti i segnali sono arrivati subito: configurazioni database gestite con leggerezza cosmica, token e chiavi API esposte, possibilità di impersonare agenti altrui.

In pratica, un ecosistema dove un errore banale scala.

La cosa più interessante, poi, è l’opacità che emerge:

- agenti che parlano di canali cifrati o linguaggi “solo per agenti” per sfuggire alla supervisione umana.

- bot che fondano religioni e spazi di dubbia natura, come Molthub (ne abbiamo parlato in un altro post)

Basta un po’ di narrativa e incentivi messi male perché il sistema converga verso comportamenti che rendono più difficile capire cosa sta succedendo.

Quindi sì: Moltbook fa ridere e genera engagement.

Ma come infrastruttura è un promemoria brutale: se rendi social e “memetiche” le capacità operative degli agenti, la superficie d’attacco non cresce linearmente. Esplode.

E a quel punto “la fiducia” resta quello che è sempre stata: non una strategia di sicurezza.

Insomma, Moltbook è il posto dove l’hype fa networking e la sicurezza resta fuori dalla chat. 🥲

Se ti interessa l’argomento, domani saremo in live sul nostro server Discord a parlarne nel nostro CaffeAI:

⏰ Venerdì 06 febbraio | 17:00 – 18:00

📍 Live sul Discord Datapizza AI Builders

Giacomo Ciarlini - CIO - Datapizza

Simone Conversano - AI Adoption Specialist - Datapizza